La galaxia NGC 1291, desde Spitzer

jueves, 30 de agosto de 2018

martes, 14 de agosto de 2018

Misión al planeta Tierra: ADM-Aeolus

Todos sabemos lo que es el aire, pero no lo vemos, ni lo tocamos, y

muchas veces, ni lo olemos. Aún así, podemos sentir sus efectos: movimiento de

hojas o de ramas de árboles, el pelo poniéndose delante de tu cara (las

personas que tengan el pelo largo lo saben bien), y cosas así. Realmente es la

manifestación del movimiento del aire, y que tendemos a llamar viento. Pero

realmente, ¿qué es el aire? Básicamente, es un fluido, y como tal, está en

continuo movimiento, desde el mismo suelo hasta las capas más altas de la

atmósfera. En la inmensa mayoría de los casos, ni nos enteramos de que se

mueve, pero lo hace, y es una de las variables más importantes (y de momento

perdidas) para construir predicciones meteorológicas fiables.

El método tradicional de calcular la velocidad y la dirección del

viento es muy preciso, pero está restringida a un único punto. Nos referimos,

por supuesto, a los anemómetros. Hacerlo de forma global es prácticamente

imposible desde Tierra, de manera que la única manera es con satélites. Pero,

¿cómo? Las imágenes de los satélites, salvo las de los meteorológicos en

órbitas geoestacionarias, sirven de poco, y otros sensores, como los de

infrarrojo, ultravioleta o microondas pasivos, tampoco son aptos. De momento la

única forma posible es hacerlo con aparatos de microondas activos, aunque están

bastante limitados.

La historia de la medición de la velocidad y dirección del viento se

remonta a la época posterior a la Segunda Guerra Mundial, con la popularización

de los sistemas de radar, que pasaron de los buques de guerra a las

embarcaciones civiles. El problema empezó cuando los marinos se quejaban cada

vez con más volumen que en malas condiciones meteorológicas el uso del radar

era inútil, imposibilitando la detección de pequeños barcos o lanchas. Los

científicos estudiaron el problema, y además de resolverlo, sin quererlo

encontraron posibilidades a esta distorsión vista. Analizando los resultados

que veían, y tras trabajar en ellos, descubrieron que la reflexión recibida,

los ecos de radar que retornaban al aparato, estaba relacionada con la

velocidad del viento en los primeros centímetros sobre la superficie de los

océanos. No solo eso, cuando

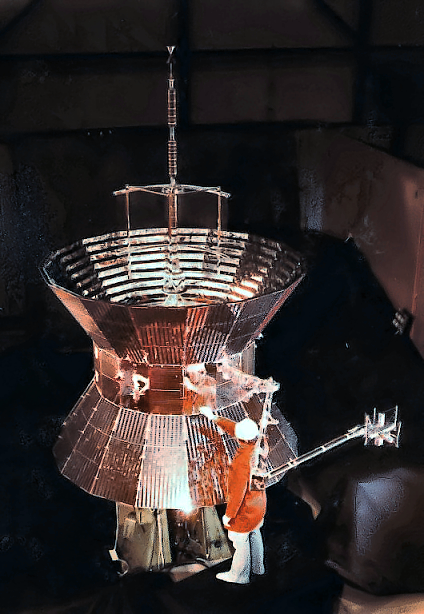

cargaron radares modificados para medir la velocidad del viento en aviones, y tras revisar lo recogido, vieron que las propias señales reflejadas estaban influenciadas por la dirección del viento. Así, relacionando el ángulo de emisión del radar con su reflexión, se podía obtener este segundo parámetro. Todo este desarrollo en radares especiales (instrumentos llamados dispersómetros) llegó en los primeros años de la era espacial, en la década de 1960, por lo que no sorprende que se tardaran todavía varios años para demostrar si esta técnica era posible desde la órbita terrestre. El primer aparato capaz en medir el viento desde el espacio era un radar experimental a bordo de la estación espacial de la NASA Skylab, que a lo largo de tres misiones tripuladas, se pudieron obtener algunas conclusiones, siendo la principal que era factible, aunque solo podía capturar la velocidad, no la dirección. Esta experiencia sirvió para desarrollar el primer dispersómetro 100% capaz de medir la velocidad y la dirección del viento. Transportado en el primer observatorio oceanográfico global de la historia, el potentísimo Seasat, fue el primero en obtener mediciones fiables tanto de la velocidad como de la dirección del viento, usando cuatro antenas tipo barra de “haz de abanico”, creando dos haces que barrían cada uno unos 600 km. de océano. Sumando las cuatro observaciones se podían obtener las mediciones de viento en cuatro direcciones posibles. Por desgracia, solo funcionó 105 días antes de que su sistema energético se averiara irreversiblemente. Tuvo que pasar otra década para ver un nuevo dispersómetro, en este caso el instalado en el satélite europeo ERS-1. Realmente formaba parte de un paquete de detección

activa que combinaba tanto el sistema de radar de imágenes SAR como el medidor de viento. El éxito fue tan grande que en 1995 se lanzó ERS-2 con un equipo idéntico, que permitió doblar la cobertura oceánica. Aún siendo menos avanzados que el de Seasat, la continuidad de datos de ambos satélites (ERS-1, de 1991 hasta el 2000, ERS-2, hasta el 2011) se ha convertido en una base de datos de referencia para la medición de vientos. La NASA no se había dormido en los laureles, y en 1996 instaló su aparato NSCAT (Dispersómetro de la NASA) en el satélite japonés ADEOS, lanzado ese mismo año. El instrumento era una solución temporal, pero completamente funcional, que usaba dos brazos conteniendo cada uno tres antenas tipo barra, creando dos barridos independientes. El satélite ADEOS (o Midori, después del lanzamiento) funcionó solo 10 meses por un problema en el panel solar que lo dejó sin energía. Sin embargo, el instrumento había sido un éxito, proporcionando información del 90% de los océanos libres de hielo, mejorando así los pronósticos. La pérdida de NSCAT en Midori provocó una rápida reacción en la NASA, ordenando la preparación y el lanzamiento, en el plazo más breve posible, de un sustituto. La solución fue el extraordinario QuikScat. Desarrollado y puesto en órbita en apenas 11 meses, un mes

cargaron radares modificados para medir la velocidad del viento en aviones, y tras revisar lo recogido, vieron que las propias señales reflejadas estaban influenciadas por la dirección del viento. Así, relacionando el ángulo de emisión del radar con su reflexión, se podía obtener este segundo parámetro. Todo este desarrollo en radares especiales (instrumentos llamados dispersómetros) llegó en los primeros años de la era espacial, en la década de 1960, por lo que no sorprende que se tardaran todavía varios años para demostrar si esta técnica era posible desde la órbita terrestre. El primer aparato capaz en medir el viento desde el espacio era un radar experimental a bordo de la estación espacial de la NASA Skylab, que a lo largo de tres misiones tripuladas, se pudieron obtener algunas conclusiones, siendo la principal que era factible, aunque solo podía capturar la velocidad, no la dirección. Esta experiencia sirvió para desarrollar el primer dispersómetro 100% capaz de medir la velocidad y la dirección del viento. Transportado en el primer observatorio oceanográfico global de la historia, el potentísimo Seasat, fue el primero en obtener mediciones fiables tanto de la velocidad como de la dirección del viento, usando cuatro antenas tipo barra de “haz de abanico”, creando dos haces que barrían cada uno unos 600 km. de océano. Sumando las cuatro observaciones se podían obtener las mediciones de viento en cuatro direcciones posibles. Por desgracia, solo funcionó 105 días antes de que su sistema energético se averiara irreversiblemente. Tuvo que pasar otra década para ver un nuevo dispersómetro, en este caso el instalado en el satélite europeo ERS-1. Realmente formaba parte de un paquete de detección

activa que combinaba tanto el sistema de radar de imágenes SAR como el medidor de viento. El éxito fue tan grande que en 1995 se lanzó ERS-2 con un equipo idéntico, que permitió doblar la cobertura oceánica. Aún siendo menos avanzados que el de Seasat, la continuidad de datos de ambos satélites (ERS-1, de 1991 hasta el 2000, ERS-2, hasta el 2011) se ha convertido en una base de datos de referencia para la medición de vientos. La NASA no se había dormido en los laureles, y en 1996 instaló su aparato NSCAT (Dispersómetro de la NASA) en el satélite japonés ADEOS, lanzado ese mismo año. El instrumento era una solución temporal, pero completamente funcional, que usaba dos brazos conteniendo cada uno tres antenas tipo barra, creando dos barridos independientes. El satélite ADEOS (o Midori, después del lanzamiento) funcionó solo 10 meses por un problema en el panel solar que lo dejó sin energía. Sin embargo, el instrumento había sido un éxito, proporcionando información del 90% de los océanos libres de hielo, mejorando así los pronósticos. La pérdida de NSCAT en Midori provocó una rápida reacción en la NASA, ordenando la preparación y el lanzamiento, en el plazo más breve posible, de un sustituto. La solución fue el extraordinario QuikScat. Desarrollado y puesto en órbita en apenas 11 meses, un mes

después de su despegue demostró

de lo que era capaz. Sin embargo, el sistema científico que cargaba, el

dispersómetro SeaWinds, era

completamente distinto a todo lo visto antes. En vez de antenas tipo barra,

usaba un reflector parabólico de 1 metro de diámetro, fijado sobre un mecanismo

rotatorio (a 18 rpm), que una vez en marcha permitía cubrir 1.800 km. de

superficie oceánica disparando dos haces levemente desviados el uno del otro, y

recibiendo la reflexión provocada por el contacto con los océanos. Con una

misión primaria de 3 años, pretendía que el hueco de datos entre NSCAT y el

siguiente SeaWinds (diseñado para ADEOS-II) fuera el mínimo. Este segundo

aparato, idéntico al de QuikScat, fue

situado en órbita en diciembre del 2002 a bordo de Midori-2, pero tuvo una vida tan poco afortunada como el primero,

ya que en octubre del 2003 el panel solar se averió (posible micrometeorito o

resto de basura espacial) y se quedó sin energía. De esta forma, la NASA tuvo

que estirar hasta los límites a QuikScat,

ocurriendo lo inevitable: en el 2009 el mecanismo de rotación de la antena se

averió, provocando que, aunque el SeaWinds

todavía funcionaba, solo cubría 25 km., de manera que desde este suceso hasta

su reentrada, sirviera como estándar de calibración. Sin embargo, cuando el

instrumento operó a máxima capacidad era una de las bases de datos más

importantes y de más alta prioridad para los pronósticos meteorológicos. La ESA también ha continuado trabajando con dispersómetros, y lo conseguido con los ERS permitió

crear el primer instrumento considerado “operacional” (empleado específicamente para pronósticos meteorológicos): el sistema ASCAT de los satélites meteorológicos polares MetOp, lanzados en el 2006 y en el 2012. A diferencia de los SeaWinds, ASCAT emplea dos juegos de antenas tipo barra para medir barridos oceánicos de 550 km. de ancho. Otras agencias también han desarrollado dispersómetros, y han sido del tipo SeaWinds. En el 2009, la agencia hindú ISRO puso en órbita su Oceansat-2, y entre su carga útil, el sistema OSCAT, con los mismos principios que los aparatos de la NASA, que por desgracia se averió en febrero del 2014. Por su parte, en septiembre del 2011 la agencia china situó sobre nosotros su HY-2A, con un sistema también de diseño inspirado en SeaWinds, este sí operacional. El más reciente añadido a la constelación de dispersómetros ha sido el ISS-RapidScat, una versión barata y rápida (usando hardware dejado de la elaboración de los dos SeaWinds) instalada en el exterior de la Estación Espacial Internacional en septiembre del 2014, con el propósito de continuar las mediciones hasta que se pueda lanzar una nueva misión 100% enfocada a ello en un futuro próximo.

crear el primer instrumento considerado “operacional” (empleado específicamente para pronósticos meteorológicos): el sistema ASCAT de los satélites meteorológicos polares MetOp, lanzados en el 2006 y en el 2012. A diferencia de los SeaWinds, ASCAT emplea dos juegos de antenas tipo barra para medir barridos oceánicos de 550 km. de ancho. Otras agencias también han desarrollado dispersómetros, y han sido del tipo SeaWinds. En el 2009, la agencia hindú ISRO puso en órbita su Oceansat-2, y entre su carga útil, el sistema OSCAT, con los mismos principios que los aparatos de la NASA, que por desgracia se averió en febrero del 2014. Por su parte, en septiembre del 2011 la agencia china situó sobre nosotros su HY-2A, con un sistema también de diseño inspirado en SeaWinds, este sí operacional. El más reciente añadido a la constelación de dispersómetros ha sido el ISS-RapidScat, una versión barata y rápida (usando hardware dejado de la elaboración de los dos SeaWinds) instalada en el exterior de la Estación Espacial Internacional en septiembre del 2014, con el propósito de continuar las mediciones hasta que se pueda lanzar una nueva misión 100% enfocada a ello en un futuro próximo.

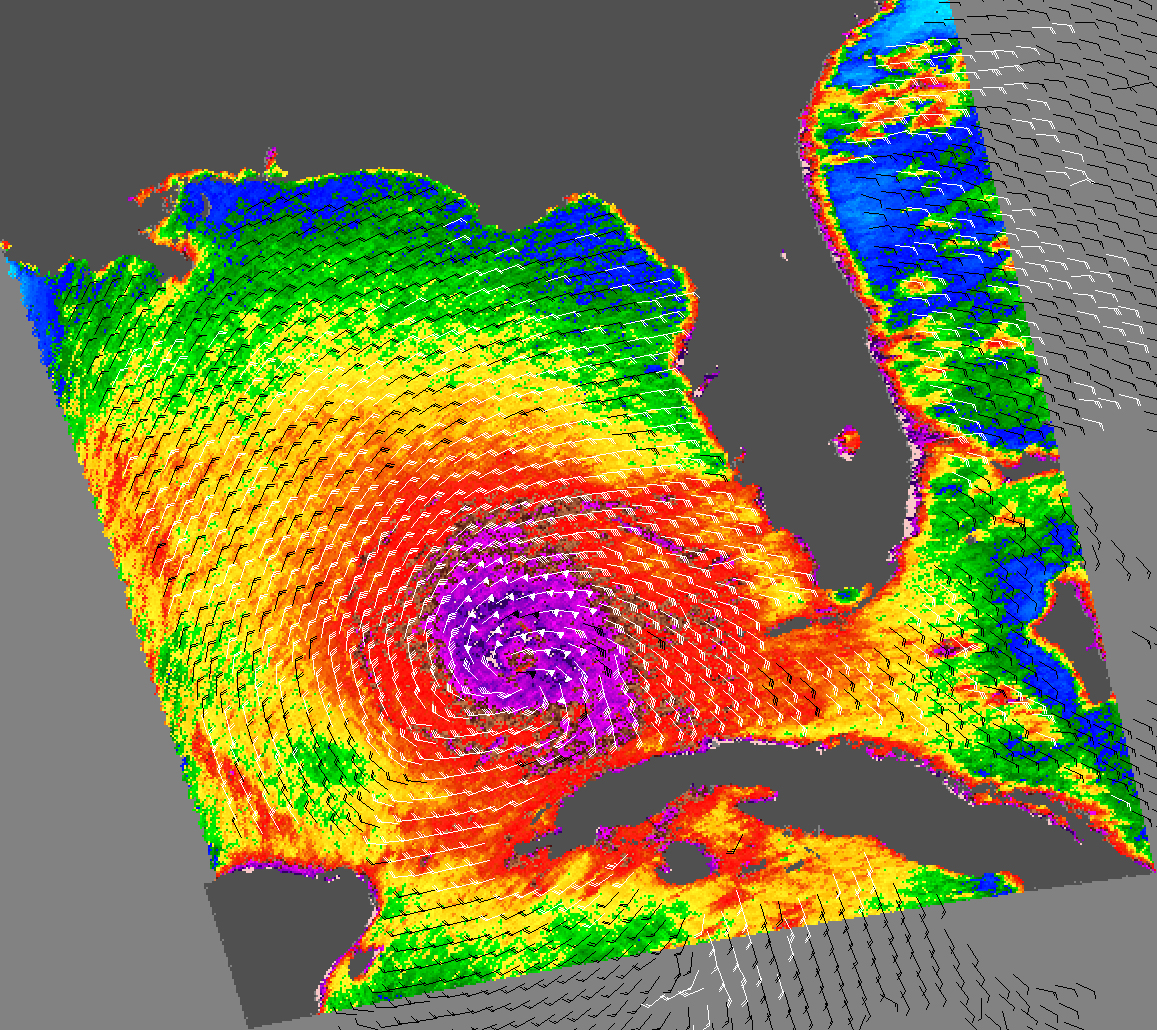

Toda esta información recolectada a lo largo de los años es muy

importante, pero está tremendamente limitada. Los dispersómetros radar, da

igual del tipo que sean, solo detectan la velocidad y dirección del viento

sobre la superficie oceánica, unos pocos centímetros por encima. Lo que quieren

los científicos y meteorólogos es información de esa misma velocidad y

dirección del viento pero en altitud. Lo ideal sería cubrir toda la atmósfera

de arriba abajo, pero hay que empezar por algo. Y para ello, es necesaria otra

aproximación.

En los últimos años ha aparecido otra técnica activa para estudiar el

sistema terrestre, salvo que emplea haces de luz en vez que ondas de radio. Nos

referimos a los sistemas LIDAR. Hasta ahora se han usado como altímetros láser (GLAS de ICESat) o sondeadores

atmosféricos (CALIOP de CALIPSO), y este nuevo uso lleva investigándose bastante tiempo. Un primer intento de desarrollar y demostrar esta técnica en el espacio se amparó en el desaparecido programa New Millenium de la NASA. El plan era situar, en la bodega de un transbordador, el sistema SPARCLE (Experimento de Lidar Coherente para Preparación para el Espacio), que tenía el propósito de probar la obtención de perfiles de viento globales hasta 16 km. de altitud sobre la superficie terrestre mediante sistemas láser, una misión cancelada. La ESA también había hecho acuse de recibo de la comunidad científica y, dentro de su serie de satélites Earth Explorer, perteneciente al programa Living Planet (que ya ha dado los GOCE, SMOS, Cryosat o Swarm), comenzó los trabajos para su misión de vientos globales.

atmosféricos (CALIOP de CALIPSO), y este nuevo uso lleva investigándose bastante tiempo. Un primer intento de desarrollar y demostrar esta técnica en el espacio se amparó en el desaparecido programa New Millenium de la NASA. El plan era situar, en la bodega de un transbordador, el sistema SPARCLE (Experimento de Lidar Coherente para Preparación para el Espacio), que tenía el propósito de probar la obtención de perfiles de viento globales hasta 16 km. de altitud sobre la superficie terrestre mediante sistemas láser, una misión cancelada. La ESA también había hecho acuse de recibo de la comunidad científica y, dentro de su serie de satélites Earth Explorer, perteneciente al programa Living Planet (que ya ha dado los GOCE, SMOS, Cryosat o Swarm), comenzó los trabajos para su misión de vientos globales.

Su nombre es ADM-Aeolus,

aunque también se la conoce solamente como Aeolus.

El acrónimo significa Misión de Dinámica Atmosférica, que es en lo que se

centrará, en recoger información de los perfiles de viento globales para a

partir de ellos ver por primera vez la evolución de la dinámica atmosférica en

el tiempo y en el espacio. Es una de las primeras misiones Earth Explorer

aprobadas, allá por el año 2000, y el desarrollo de su sistema de medición ha

sido tan complejo que su lanzamiento ha tenido que ser repetidamente desplazado

a lo largo de los años hasta que al fin, todo está listo para su puesta en

órbita. Ahora veamos el por qué de tanto retraso.

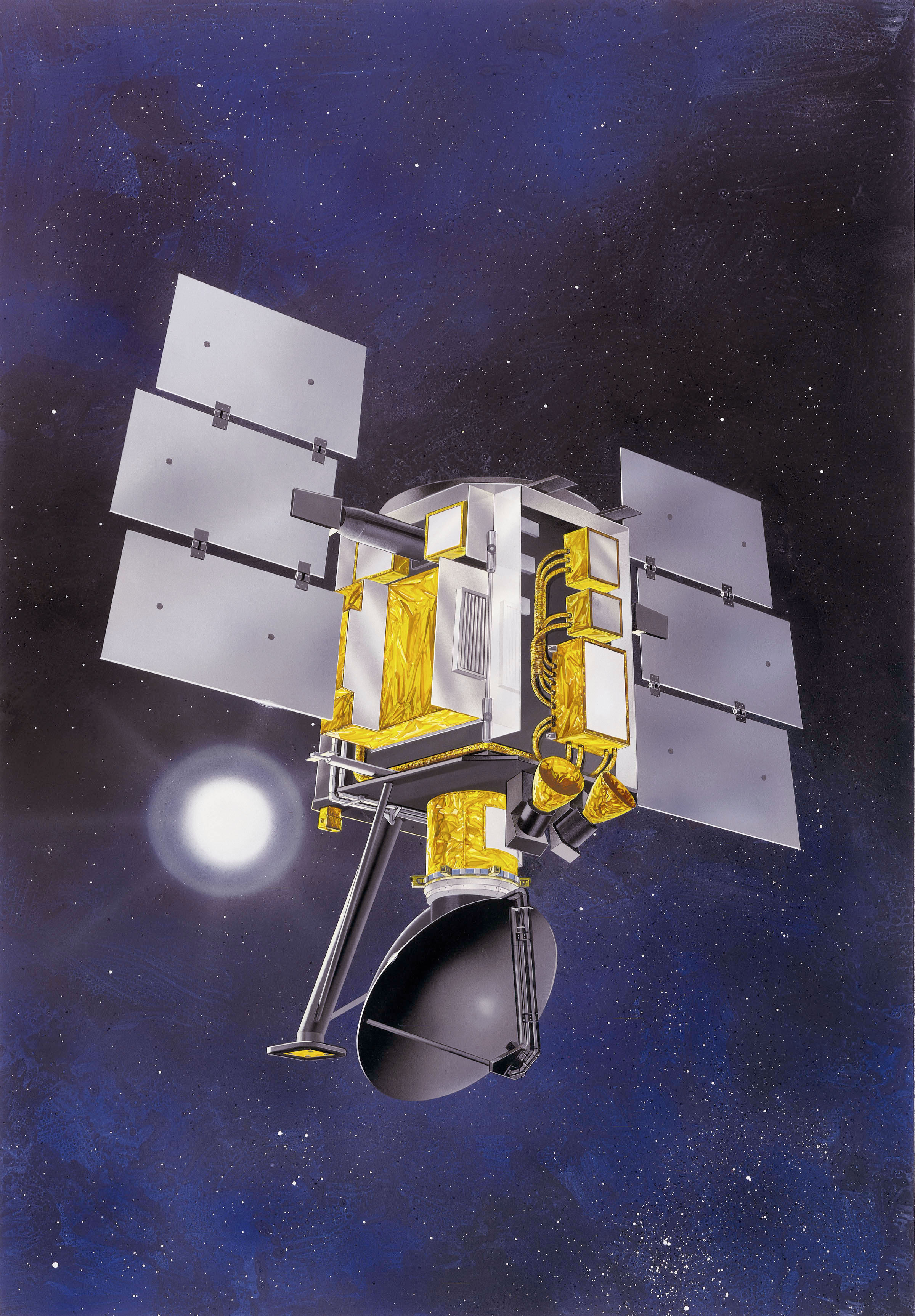

Una vez desplegado en órbita, ADM-Aeolus

recuerda al satélite NASA-CNES CALIPSO,

aunque es algo más grande. Se divide en el bus de satélite y en el instrumento,

con unas medidas de 4.3 x 1.9 x 2 metros, y una envergadura de paneles solares

de unos 13 metros. A diferencia de otros satélites terrestres, su plataforma no

pertenece a las bases comunes tan ampliamente usadas ahora, sino que deriva

directamente de la estructura desarrollada para la sonda marciana Mars Express. Es una estructura

elaborada en aluminio, empleando láminas homogéneas y secciones en estructura

de panal de abeja, albergando en su interior casi todo lo necesario para

funcionar. Así, la infraestructura informática está centralizada alrededor de

un procesador ERC-32 con 6 MB de memoria RAM, complementado por un grabador de

a bordo con capacidad de 8 GB de información, tanto telemetría de ingeniería

como los datos de su único instrumento. Su software de vuelo permite

operaciones autónomas de hasta cinco días de duración. Las comunicaciones son

las ya habituales: banda-S (dos antenas omnidireccionales) para envío de

comandos y descarga de datos, y banda-X (antena de alta ganancia en el lado del

satélite que apunta a la Tierra) para transmisión de información a alta

velocidad. Está diseñado para estar estabilizado en sus tres ejes manteniendo

una actitud muy estable. Para ello emplea unidades de medición y ratio

inerciales, sensores solares-terrestres ordinarios, dos escáneres estelares

autónomos (montados en el instrumento), receptor GPS, ruedas de reacción, un

magnetómetro con sistemas de descompensación magnética, además de cinco

propulsores, para correcciones orbitales y maniobras para elevación hasta la

altura de trabajo, todo para saber la localización exacta del satélite con un

margen de error menor a 10 metros. La generación de energía depende de los

paneles solares. Cada uno tiene tres secciones, totalizando 13.4 metros

cuadrados de superficie activa, equipa células solares de alta eficiencia, y

además de proporcionar energía suficiente para funcionar también carga una

batería de ion-litio. Para el bus el control termal es el habitual: mantas multicapa,

calentadores y radiadores eléctricos. El instrumento tiene su propio control

termal. La única herramienta científica de a bordo es ALADIN, el Instrumento Láser Doppler Atmosférico. Como otros sistemas

LIDAR, emplea un emisor láser,

un telescopio receptor y las electrónicas receptoras, las que hacen el

verdadero trabajo. Realmente dispone de dos emisores láser por redundancia, y

es del tipo usual empleado en misiones espaciales. Sin embargo, aunque emite en

longitud de onda infrarroja (1.06 micrones), esta emisión pasa por todo un

complejo camino hasta acabar en un par de cristales de generación harmónica

transformando el haz emitido a luz ultravioleta (355 nanómetros), invisible a

simple vista y seguro para todas las formas de vida animal del planeta. Todo

este sistema de generación de pulsos láser necesita estar enfriado lo

suficiente para evitar averías, por lo que dispone de toda una serie de caminos

que llevan el calor generado a un radiador externo fijado a uno de los

laterales de la plataforma del satélite, el opuesto que apunta al Sol. Una vez

emitido el haz laser en ultravioleta, y tras hacer el camino de ida y vuelta, llega al telescopio receptor. Es de diseño Cassegrain, con un espejo primario de 1.5 metros (f/0.9), estando construido íntegramente en carburo de silicio por su

tremendamente alto

coeficiente de expansión y retracción termal, además de ser sumamente ligero

(53 kg.). Una vez en el telescopio la luz se enfoca y viaja al conjunto

receptor. Se divide en dos sistemas independientes fijados en el OBA

(Ensamblaje de Soporte Óptico), una placa base rígida de fibra de carbono. Son

dos espectrómetros: el Espectrómetro Mie (nombrado por la dispersión del mismo

nombre, que hace referencia a la dispersión de la luz por partículas mayores

que la longitud de onda de la luz, en esencia es lo que hace que las nubes sean

blancas) se basa en un interferómetro (tipo Fizeau) que emplea dos placas

parcialmente reflectoras (separadas 68.5 milímetros) en el que se induce una

inclinación proporcionando una dispersión espectral lineal. En este sistema, la

señal recibida crea un margen lineal, cuya posición está determinada por el

efecto Doppler inducido por la dirección del viento. Todo esto es recogido por

un tipo de detector CCD (conocido como ACCD) que tiene una sección de imagen

(16 x 16 pixels) y una sección de memoria (25 líneas); y el Espectrómetro

Rayleigh (por la dispersión del mismo nombre, que se refiere a la dispersión de

la luz por las moléculas del aire, como el nitrógeno y el oxígeno, y que es responsable

del azul del cielo) es un etalón doble de tipo Fabry-Pérot, en el que la luz

recogida por el telescopio pasa por un polarizador hacia uno de los dos etalón,

que recoge el componente espectral de la luz que le ha llegado, mientras que el

resto es reflejado a otro polarizador, y de ahí, a otro etalón. Las salidas de

los dos etalón se enfocarán en un ACCD formando dos puntos. Además de detectar

la reflexión provocada por la dispersión Rayleigh, este espectrómetro está

preparado para obtener perfiles de aerosoles atmosféricos. Todo el sistema

ALADIN pesa unos 480 kg., la masa seca del satélite es de 1.100 kg., y una vez

a plena carga en el momento del lanzamiento declarará un desplazamiento de 1450 kg.

tremendamente alto

coeficiente de expansión y retracción termal, además de ser sumamente ligero

(53 kg.). Una vez en el telescopio la luz se enfoca y viaja al conjunto

receptor. Se divide en dos sistemas independientes fijados en el OBA

(Ensamblaje de Soporte Óptico), una placa base rígida de fibra de carbono. Son

dos espectrómetros: el Espectrómetro Mie (nombrado por la dispersión del mismo

nombre, que hace referencia a la dispersión de la luz por partículas mayores

que la longitud de onda de la luz, en esencia es lo que hace que las nubes sean

blancas) se basa en un interferómetro (tipo Fizeau) que emplea dos placas

parcialmente reflectoras (separadas 68.5 milímetros) en el que se induce una

inclinación proporcionando una dispersión espectral lineal. En este sistema, la

señal recibida crea un margen lineal, cuya posición está determinada por el

efecto Doppler inducido por la dirección del viento. Todo esto es recogido por

un tipo de detector CCD (conocido como ACCD) que tiene una sección de imagen

(16 x 16 pixels) y una sección de memoria (25 líneas); y el Espectrómetro

Rayleigh (por la dispersión del mismo nombre, que se refiere a la dispersión de

la luz por las moléculas del aire, como el nitrógeno y el oxígeno, y que es responsable

del azul del cielo) es un etalón doble de tipo Fabry-Pérot, en el que la luz

recogida por el telescopio pasa por un polarizador hacia uno de los dos etalón,

que recoge el componente espectral de la luz que le ha llegado, mientras que el

resto es reflejado a otro polarizador, y de ahí, a otro etalón. Las salidas de

los dos etalón se enfocarán en un ACCD formando dos puntos. Además de detectar

la reflexión provocada por la dispersión Rayleigh, este espectrómetro está

preparado para obtener perfiles de aerosoles atmosféricos. Todo el sistema

ALADIN pesa unos 480 kg., la masa seca del satélite es de 1.100 kg., y una vez

a plena carga en el momento del lanzamiento declarará un desplazamiento de 1450 kg.

tremendamente alto

coeficiente de expansión y retracción termal, además de ser sumamente ligero

(53 kg.). Una vez en el telescopio la luz se enfoca y viaja al conjunto

receptor. Se divide en dos sistemas independientes fijados en el OBA

(Ensamblaje de Soporte Óptico), una placa base rígida de fibra de carbono. Son

dos espectrómetros: el Espectrómetro Mie (nombrado por la dispersión del mismo

nombre, que hace referencia a la dispersión de la luz por partículas mayores

que la longitud de onda de la luz, en esencia es lo que hace que las nubes sean

blancas) se basa en un interferómetro (tipo Fizeau) que emplea dos placas

parcialmente reflectoras (separadas 68.5 milímetros) en el que se induce una

inclinación proporcionando una dispersión espectral lineal. En este sistema, la

señal recibida crea un margen lineal, cuya posición está determinada por el

efecto Doppler inducido por la dirección del viento. Todo esto es recogido por

un tipo de detector CCD (conocido como ACCD) que tiene una sección de imagen

(16 x 16 pixels) y una sección de memoria (25 líneas); y el Espectrómetro

Rayleigh (por la dispersión del mismo nombre, que se refiere a la dispersión de

la luz por las moléculas del aire, como el nitrógeno y el oxígeno, y que es responsable

del azul del cielo) es un etalón doble de tipo Fabry-Pérot, en el que la luz

recogida por el telescopio pasa por un polarizador hacia uno de los dos etalón,

que recoge el componente espectral de la luz que le ha llegado, mientras que el

resto es reflejado a otro polarizador, y de ahí, a otro etalón. Las salidas de

los dos etalón se enfocarán en un ACCD formando dos puntos. Además de detectar

la reflexión provocada por la dispersión Rayleigh, este espectrómetro está

preparado para obtener perfiles de aerosoles atmosféricos. Todo el sistema

ALADIN pesa unos 480 kg., la masa seca del satélite es de 1.100 kg., y una vez

a plena carga en el momento del lanzamiento declarará un desplazamiento de 1450 kg.

tremendamente alto

coeficiente de expansión y retracción termal, además de ser sumamente ligero

(53 kg.). Una vez en el telescopio la luz se enfoca y viaja al conjunto

receptor. Se divide en dos sistemas independientes fijados en el OBA

(Ensamblaje de Soporte Óptico), una placa base rígida de fibra de carbono. Son

dos espectrómetros: el Espectrómetro Mie (nombrado por la dispersión del mismo

nombre, que hace referencia a la dispersión de la luz por partículas mayores

que la longitud de onda de la luz, en esencia es lo que hace que las nubes sean

blancas) se basa en un interferómetro (tipo Fizeau) que emplea dos placas

parcialmente reflectoras (separadas 68.5 milímetros) en el que se induce una

inclinación proporcionando una dispersión espectral lineal. En este sistema, la

señal recibida crea un margen lineal, cuya posición está determinada por el

efecto Doppler inducido por la dirección del viento. Todo esto es recogido por

un tipo de detector CCD (conocido como ACCD) que tiene una sección de imagen

(16 x 16 pixels) y una sección de memoria (25 líneas); y el Espectrómetro

Rayleigh (por la dispersión del mismo nombre, que se refiere a la dispersión de

la luz por las moléculas del aire, como el nitrógeno y el oxígeno, y que es responsable

del azul del cielo) es un etalón doble de tipo Fabry-Pérot, en el que la luz

recogida por el telescopio pasa por un polarizador hacia uno de los dos etalón,

que recoge el componente espectral de la luz que le ha llegado, mientras que el

resto es reflejado a otro polarizador, y de ahí, a otro etalón. Las salidas de

los dos etalón se enfocarán en un ACCD formando dos puntos. Además de detectar

la reflexión provocada por la dispersión Rayleigh, este espectrómetro está

preparado para obtener perfiles de aerosoles atmosféricos. Todo el sistema

ALADIN pesa unos 480 kg., la masa seca del satélite es de 1.100 kg., y una vez

a plena carga en el momento del lanzamiento declarará un desplazamiento de 1450 kg.

ADM-Aeolus ha sido diseñado

para ser lanzado en una amplia variedad de lanzadores medios y ligeros, y el

seleccionado al final fue el polivalente Vega

europeo. El lanzamiento se producirá desde el Puerto Espacial de la Guayana

Francesa en Kourou el 21 de agosto. Una vez completado todo el proceso, y tras las maniobras

del satélite posteriores a su liberación, se encontrará en una órbita cercana a

la línea amanecer-anochecer, casi polar, sincrónica solar, a 320 km. de altitud

sobre la Tierra.

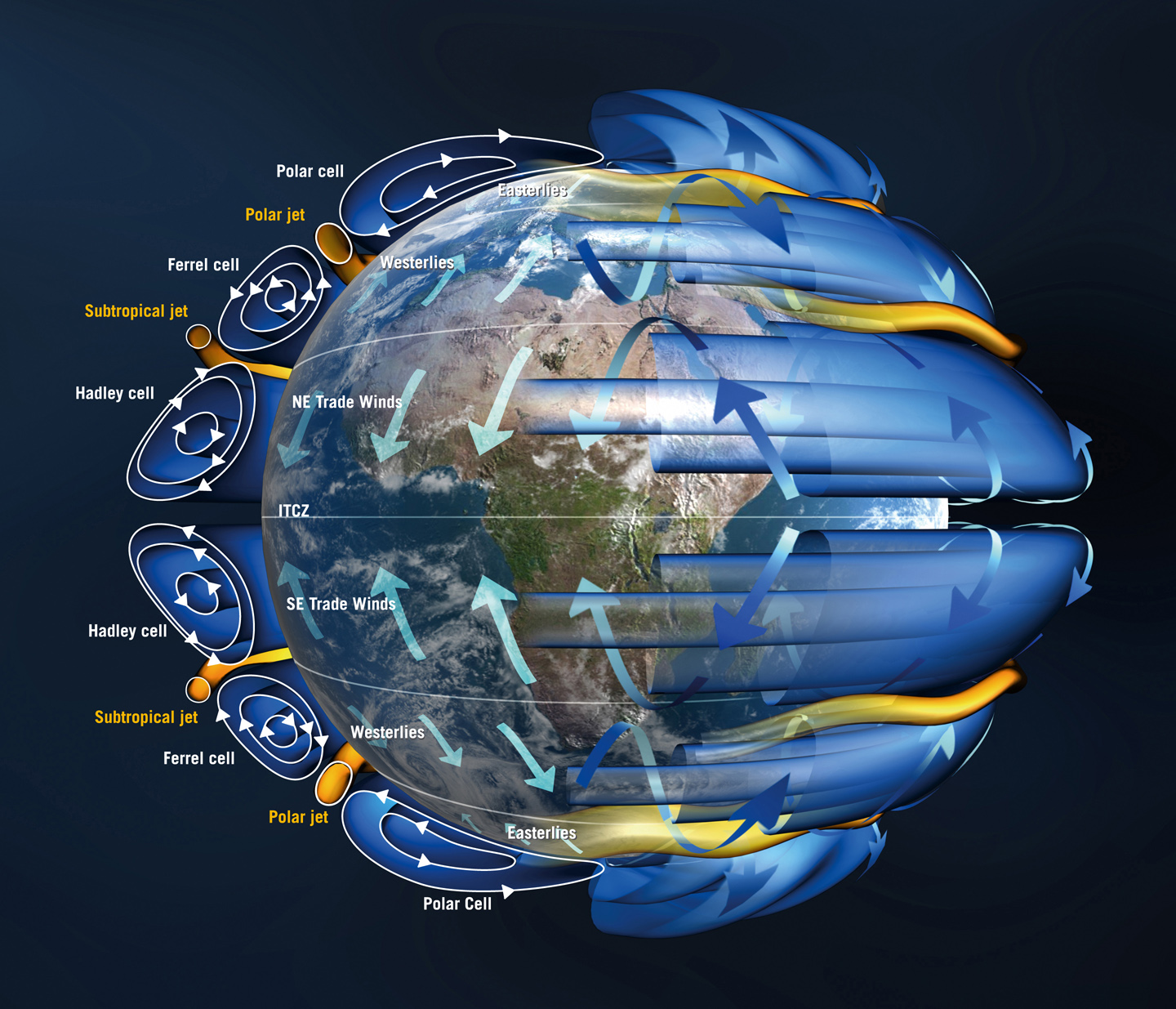

Como ya hemos dicho, el aire es un fluido que está en continuo

movimiento, lo que no hemos dicho es que dependiendo de la altitud la velocidad

cambia, pero también dependiendo de la latitud. Pero más que nada como en otros

ámbitos del sistema terrestre, depende de la energía solar que entre. Como las

regiones ecuatoriales reciben más luz solar, esto empieza a manejar los vientos

llevando esa energía hacia los polos, donde este aire calentado se enfría, para

luego volver a las zonas ecuatoriales a volverse a calentar. Algo así como la

circulación oceánica se da en la atmósfera. Se suele explicar la circulación

atmosférica en células y corrientes de chorro. Tenemos las células Polares,

células Ferrel y células Hadley, y las corrientes polares y subtropicales. Pero

es que además, por la llamada fuerza Coriolis, los vientos fluyen generalmente

en dirección a la derecha en el hemisferio norte, y a la izquierda en el sur.

Todo el movimiento del aire (el viento, para entendernos) está equilibrado por

la diferencia de presión atmosférica, dividida en los ciclones (aire caliente

en elevación) y anticiclones (aire frío descendente), variando solo cuando toca

una zona con una distinta presión. Sobre las corrientes de chorro, son fajas

estrechas de aire moviéndose a muy altas velocidades extendiéndose miles de km.

de largo, pero pocos de ancho, actuando como fronteras entre masas de aire de

distinta temperatura, de ahí la separación de las células, salvo en el ecuador.

Por su parte, las células manejan la circulación. Las células Hadley

(extendiéndose hasta 30º latitud norte y sur, y separadas por la Zona de

Convergencia Intertropical, ITCZ, situada sobre el ecuador terrestre) están

caracterizadas por un flujo ascendente del aire cerca de la superficie en bajas

latitudes, y uno descendente a altas latitudes. Las células Ferrel (entre 30º y

60º latitud norte y sur) equilibran el transporte entre las células Hadley y

las polares, y las corrientes de chorro suelen estar encajadas entre estas

células, aunque en las veces en que las Ferrel y las Hadley se mezclan en

ciertas latitudes, a éstas se las conocen como Latitudes Horse. Por su parte,

las células polares manejan la circulación en las regiones polares. Como podéis

ver, el viento no soplará con la misma intensidad en dos puntos distintos, ni a

dos altitudes distintas, por lo que ADM-Aeolus

apunta a recoger perfiles de viento globales, es decir, la velocidad y

dirección del viento dependiendo de la altitud.

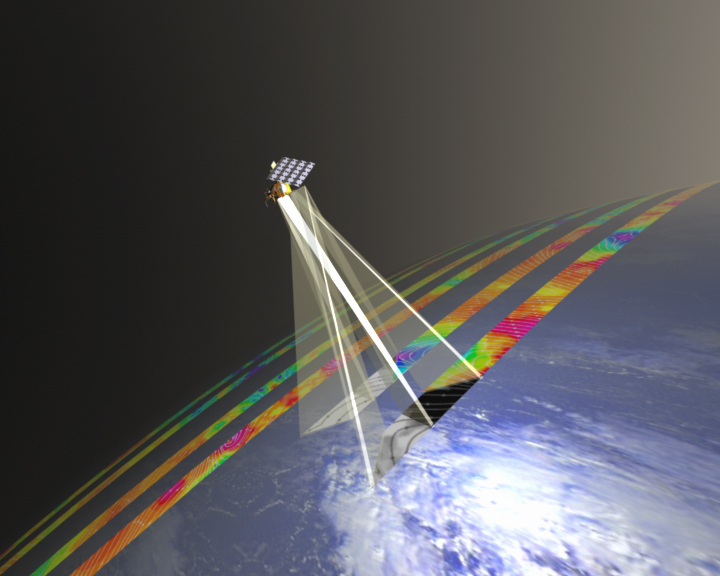

Una vez situado en posición, y tras acabar el periodo de puesta a

punto de tres meses, ADM-Aeolus no

apuntará su ALADIN a la vertical terrestre; lo hará con una inclinación de 35º

fuera de la vertical en dirección antisolar. Esto se hace para optimizar la

recepción de las señales láser emitidas por el instrumento y reflejadas por la

atmósfera. Para obtener el perfil de viento, ALADIN emitirá una ráfaga de

disparos láser de 7 segundos de duración, lo que le permitirá cubrir 50 km. de

longitud completando unas 700 mediciones. Entre ráfaga y ráfaga el satélite se

trasladará en su órbita lo suficiente como para dejar un hueco entre mediciones

de 200 km. La órbita se ha diseñado de tal manera que tiene un ciclo de

repetición de 7 días, por lo que cada semana volverá al mismo punto. Para medir

realmente los dos parámetros se emplea el efecto Doppler, en concreto, este

fenómeno en las dispersiones a las que es sensible ALADIN. De esta forma,

mientras el láser emite en una longitud de onda muy concreta continuamente,

tanto las moléculas de aire como las partículas de aerosol o las gotas de agua en las nubes provocan que la reflexión de vuelta al instrumento tenga distinta frecuencia. A partir de este desplazamiento Doppler provocado por la

atmósfera,

se podrán generar los perfiles de viento, y en cada segmento de 50 km., hacer

una media de la velocidad y la dirección del viento. A partir de las mediciones

que obtenga, el proyecto espera conseguir: medir perfiles de viento globales

hasta una altitud de 30 km.; medir el viento a una exactitud de 1 metro por

segundo hasta una altitud de 2 km. sobre la superficie; medir el viento con una

exactitud de 2 metros por segundo hasta 16

km. de altitud; determinar la velocidad media del viento sobre marcas de

50 km.; y medir 120 perfiles de viento por hora. Toda la información que recoja

será transmitida una vez por órbita (90 minutos aproximadamente) a la estación

de tierra en Svalbard, Noruega. La misión primaria durará un máximo de tres

años.

Una vez los datos en el centro de control, y tras un rápido procesado,

serán transmitidos a las agencias meteorológicas para que puedan hacer buen uso

de ellos. De esta forma, todo el sistema se ha diseñado para ser lo más rápido

posible en la entrega de productos científicos, de manera que puedan incluirse

en los modelos de predicción meteorológica numérica. Esta información traerá

beneficios en cuanto a pronosticar eventos extremos de la meteorología. Pero la

ciencia también hará uso amplio de la información que proporcione ADM-Aeolus para hacer estudios

climatológicos, principalmente para saber cómo trabaja la atmósfera, ayudando a

predecir hacia donde puede ir el Cambio Climático.

Si la misión tiene éxito, es probable que instrumentos como ALADIN se

popularicen y acaben en satélites meteorológicos operacionales, lo que traerá

grandes beneficios tanto a la ciencia como a la meteorología. Como pionero en

esta técnica, ADM-Aeolus será sin

duda la referencia con quien comparar. Suerte.

sábado, 4 de agosto de 2018

Las próximas misiones al Sol: Parker Solar Probe

¿Os acordáis de las sondas solares germano-estadounidenses Helios? ¿Si? Pues bien, hoy vamos a hablar de una misión que hará que la de ellas no sea más que un agradable paseo por el campo. Enseguida sabréis por qué.

La génesis de esta misión hay que datarla nada menos que en 1958. En octubre de ese año, la Comisión de Estudios Espaciales del Comité de Investigación Nacional emitió un célebre informe nacido del denominado Comité Simpson, publicado el 24 de ese mismo mes. Ahí se recomendaba vivamente la preparación de una misión directa al Sol para estudiar lo que hay en la región entre Mercurio y nuestra estrella. A lo largo de ese tiempo, cada ciertas épocas, se ha seguido lanzando la recomendación, y algunos grupos haciendo borradores de una misión con estas intenciones. Pero durante cinco décadas, la tecnología no había madurado lo suficiente. se necesitaba un salto tecnológico para poder hacerla posible. Y este salto se produjo para una misión diferente: el orbitador de Mercurio, MESSENGER. Esta formidable sonda fue equipada por un escudo solar fabricado usando materiales resistentes al calor, capaces de soportar altas temperaturas sin transferirlas al cuerpo de la sonda. Si se podía aplicar este mismo concepto, pero más grande, a la misión solar, se daría un primer paso para su realización real. Después de dos informes (años 2003 y 2013) en los que se recomendaba la implementación inmediata de un proyecto de este tipo. Al final, el Laboratorio de Física Aplicada de la Universidad Johns Hopkins fue la organización que aceptó el reto de construirla. Ha pasado por diversos nombres, primero Solar Probe, para luego ser renombrada Solar Probe Plus.

Uno de los mayores problemas acerca del Sol es la corona (su atmósfera), y el viento solar. La corona solar, extrañamente, está más caliente que la superficie solar, la fotosfera y todo indica la existencia de una transferencia de energía entre ambas regiones que lo provoca, y aunque los observatorios actuales solo pueden verlo desde lejos (SOHO, STEREO, Hinode, SDO, IRIS), nos perdemos gran parte de la película. En cuanto al viento solar (predecido antes de la era espacial por un visionario artículo redactado por el profesor Eugene Parker), se sabe que su origen es precisamente la corona solar, pero la razón por la que se emite, y qué partículas emite, es un pequeño misterio. Muchas misiones han muestreado el viento solar desde distintas distancias solares, y alguna incluso nos trajo muestras de las partículas emitidas por el Sol para su análisis, un proceso que todavía continua. Pero en general, estas misiones registran el viento solar cuando ya ha recibido cambios a lo largo del sistema solar. Por ello, para tomar datos reales sobre lo que ocurre en la corona y del viento solar en el momento de salir despedido al espacio, hay que meterse, como suele decirse, hasta la mismísima cocina.

El diseño de esa sonda ha sido un verdadero reto. Tendrá que entrar en la corona, soportar temperaturas altísimas, y sobrevivir para contarlo. Por ello, se ha recurrido a todo tipo de estrategias para crear un escudo efectivo tras el cual debe ir el resto de la sonda. Ninguna sonda se ha atrevido a ir a donde tiene previsto hacerlo esta, lo más próximo fue el acercamiento de Helios 2, pasando a 0.28 unidades astronómicas de la superficie solar. Solar Probe Plus tiene previsto acercarse a unos abrasadores 0.0459 unidades astronómicas, algo así como 6.2 millones de km. de la fotosfera de nuestra estrella, obteniendo activamente datos y soportando en las superficies expuestas temperaturas superiores a los 1400º C, mientras que el resto de la sonda trabaja en un entorno mucho más benigno. El esfuerzo de investigación ha sido notable,

encontrando materiales capaces de soportar estas temperaturas sin deshacerse, aguantar oleadas brutales de radiación, y al tiempo acumular información de una de las regiones desconocidas del sistema solar. En mayo del 2017, la NASA decidió renombrar la sonda como Parker Solar Probe, para honrar al profesor Eugene Parker, el autor de ese visionario artículo sobre el viento solar. Se da la circunstancia de que es la primera vez que la NASA renombra una misión honrando una persona viva, el resto de las veces lo ha hecho con individuos fallecidos.

encontrando materiales capaces de soportar estas temperaturas sin deshacerse, aguantar oleadas brutales de radiación, y al tiempo acumular información de una de las regiones desconocidas del sistema solar. En mayo del 2017, la NASA decidió renombrar la sonda como Parker Solar Probe, para honrar al profesor Eugene Parker, el autor de ese visionario artículo sobre el viento solar. Se da la circunstancia de que es la primera vez que la NASA renombra una misión honrando una persona viva, el resto de las veces lo ha hecho con individuos fallecidos.

Parker Solar Probe pertenece al programa Living with a Star, uno de los programas de heliofísica de la NASA, que se encarga de estudiar la relación Sol-Tierra para comprender los efectos en la vida y en la sociedad, y una vez en el espacio, se unirá a sus predecesores del programa, el observatorio de dinámica solar SDO (el observatorio solar más potente actualmente) y el dúo del cinturón de radiación Van Allen Probes. Ambas misiones están en periodo extendido, y siguen retornando datos muy importantes sobre Helios la primera, y lo que acontece en los cinturones de Van Allen la segunda, y Parker Solar Probe será un tercer y magnífico añadido a todas las misiones solares actualmente en servicio. Ahora, hablemos de la sonda.

Su diseño es muy distinto a todo lo que hemos visto hasta ahora, porque todo está concentrado en su protección termal, que es lo que ha conducido el diseño general, y a partir de lo cual se ha desarrollado el resto. Se divide en dos partes: el escudo solar, y la sonda propiamente dicha. En total, la sonda mide 3 metros de alto, 2.3 metros de ancho máximo, además de otros tres metros de envergadura, con los paneles solares desplegados, y otros 3.73 metros del mástil desplegable. El verdadero núcleo de la misión es el escudo solar, como se le conoce en la misión, el Sistema de Protección Termal, o TPS. Tiene que soportar un nivel de irradiación solar 475 veces el que recibimos en la Tierra, y permitir que la sonda, tras él, funcione a temperaturas "agradables". Si importantes son sus medidas, también su grosor, con 11.43 centímetros en total. Está elaborado usando dos capas de carbono-carbono (empleado, entre otras cosas, en secciones del escudo de reentrada del transbordador), superior e inferior, y espuma de carbono entre medias, todo para absorber el máximo de calor, evitar que llegue a la sonda, y además soportar impactos de micrometeoritos a altísimas velocidades.

En la cara que dará al Sol, un recubrimiento reflejará todavía más la luz para no iluminar en exceso el escudo. La intención no solo es proteger la sonda tras él, es la de crear una zona de sombra (la umbra) en la que los distintos apéndices que, en condiciones normales sobresaldrían, queden dentro de ella durante los perihelios. El TPS se une al resto de la sonda con un ensamblaje de soporte en forma de viga, construida usando tubos elaborados en grafito. De esta manera, se pone cierta distancia entre el TPS y la plataforma. El bus es un prisma hexagonal, de 1 metro de diámetro, y ofrece las superficies de montaje interno y externo para los distintos componentes. Se ha construido en aluminio, por ligereza y resistencia. Por toda ella, se han instalado los distintos componentes, tanto internamente como externamente. Su sistema informático se basa en un módulo de electrónicas integrado o IEM, usando con éxito en misiones como MESSENGER o New Horizons, pero con una configuración distinta: en esta ocasión alberga nada menos que triple redundancia en los componentes principales, como la tarjeta del procesador, grabador de estado sólido, y otros elementos. Por primera vez en una misión de la NASA, el

procesador empleado es el LEON3, estrenado en el espacio por la misión europea PROBA, aún en funciones, y ofrece rendimiento más que de sobra para todas las funciones de a bordo. La idea de la triple redundancia es la de poder continuar las operaciones en caso de problemas (reseteo, fallo, etc) en el procesador principal. De los tres, uno de ellos es el primario, gestionando todas las operaciones de a bordo, mientras que el segundo está como repuesto en caliente, listo para tomar el mando si el primario sufre alguna contingencia, y el tercero está como repuesto en frío. Un controlador de redundancia será quien tome la decisión de saltar de procesador a procesador, activándolos y desactivándolos como mejor convenga a la misión. La intención es no perder ni un momento de recogida de datos, que se irán guardando en los grabadores asociados al procesador principal y al situado en condición de repuesto en caliente. Cada grabador puede almacenar hasta 128 Gb de datos, suficiente para dos órbitas en torno al Sol. Para transmitir todo este flujo a Tierra, usa distintas configuraciones en su sistema de comunicación. Parker Solar Probe emplea un sistema de banda dual, de banda-X y banda-Ka, y la distribución de antenas es, cuanto menos, curiosa. Como toda sonda de espacio profundo, equipa una antena parabólica de alta ganancia, y esta es de 0.6 metros de diámetro, y móvil para poder apuntarla hacia la Tierra. Trabaja exclusivamente en banda-Ka, para transmitir datos a alta velocidad al centro de control (167 kbps). El resto usa banda-X, y son un par de antenas de media ganancia (tipo haz de abanico) y un par de baja ganancia. La antena principal y las de media ganancia se ubican en un único lado (el opuesto al orbital) y las de baja ganancia una está en el lado que siempre mirará en la dirección orbital, y la otra en el contrario. Se da la particularidad que esta misión estrena, en el espacio profundo, un nuevo tipo de radio, desarrollada en el APL, denominada Frontier Radio, cuyos prototipos van en las Van Allen Probes, y para Parker Solar Probe se ha tenido que cualificar el diseño para volar al espacio profundo, de ahí su denominación (Frontier DS). No es que las radios tipo SDST ya no sean válidas (de hecho lo son, y mucho), solo que en el APL les gusta usar desarrollos propios, por ello CONTOUR y New Horizons usaban sistemas propios, desarrollados en el Laboratorio. En cuanto a la generación de energía, lo dicho, paneles solares. Los de esta misión son pequeños, por necesidad, de 1.12 metros de largo y 0.69 de ancho, totalizando 1.55 metros cuadrados de superficie activa, por lo que proporcionarán energía limitada. Cada uno está situados al extremo de un mástil móvil, que se pliega y despliega dependiendo de la distancia solar. el propósito es esconder la sección principal de cada panel (con células de alta eficiencia, herencia MESSENGER) en la umbra creada por el TPS, pero dejar solo las puntas, la sección secundaria, fuera, en una zona de penumbra, que proporcionará hasta 400 W de electricidad en cada perihelio. Las células en la sección secundaria son distintas, y además de alta eficiencia, también son altamente tolerantes a las altas temperaturas, aunque no a las que tendrán que soportar. Estas secciones secundarias tienen una mínima inclinación hacia delante, que les sirve para poder salir de la sombra del TPS. Las células se han situado sobre una lámina de titanio, cuerda por cuerda, siguiendo el ancho del sustrato de titanio. Lo verdaderamente novedoso es que las células solares están refrigeradas de manera activa, un circuito cerrado envía líquido refrigerante para bajar la temperatura y protegerlas del intenso calor. Todo el conjunto de refrigeración se llama SACS, Sistema de Refrigeración de los Paneles Solares, y como líquido refrigerante usa un elemento que cualquiera podría descartar: agua. En realidad, se trata de agua a presión, porque en este estado es más capaz de absorber calor sin evaporarse. Todo el sistema es un circuito cerrado, que bombea el agua a presión (cinco litros en total) desde el tanque de almacenamiento hasta los paneles, de ahí se lleva el calor hasta dos enormes radiadores de tubos de titanio situados en la estructura que soporta el TPS, y luego vuelve al tanque. El sistema es realmente efectivo, capaz de disipar hasta 6500 vatios de calor y mantener las células solares en las secciones secundarias a unos más templados 150º C. A pesar de estar la energía limitada, las electrónicas son de bajo consumo, y a distancias inferiores a la unidad astronómica generan la suficiente para activar todos los sistemas de a bordo, y cargar una batería de ión litio. Estará estabilizada en sus tres ejes, y para ello recurre a lo habitual: unidad de medición inercial, dos escáneres estelares, sensores solares, 4 ruedas de reacción y propulsores. Como con MESSENGER, los requerimientos de actitud son severos. En la fase de perihelio (11 días en total) Parker Solar Probe debe ofrecer, por obligación, el TPS hacia el Sol para crear la umbra. La sonda mantendrá la posición primordialmente usando un juego de sensores solares denominados SLS, sensores de limbo solar, que se proyectan desde la plataforma, y señalarán al sistema de control de actitud una violación en los requisitos, para que la sonda maniobre de vuelta a la actitud óptima. Todas las maniobras se realizarán usando las ruedas de reacción, desaturadas por los propulsores, que porta en total 12, que se usarán también para correcciones de rumbo. El resto del control termal es más bien básico: mantas multicapa, ventanillas de apertura por termostato, tratamientos superficiales y calentadores eléctricos. Parker Solar Probe es la sonda que más autonomía incorporará, por necesidad principalmente, en sus operaciones y en su protección contra fallos. Aunque todo estará guiado por los comandos cargados desde el centro de control, la sonda realmente requiere poca atención, siendo capaz de realizar cualquier cosa por sí misma. A diferencia de otras sondas, que poseen ordenadores propios para controlar su actitud, Parker Solar Probe lo ejecuta todo en el ordenador de a bordo. Por su orden, pliega o despliega los paneles solares, mantiene o corrige su actitud, y responde a cualquier anomalía surgida a bordo. De esta forma, su software de protección contra fallos posee mucha más autoridad que sistemas similares. No solo detectará y aislará los problemas que surjan (que con condiciones normales provocaría un modo seguro), sino que también tratará de resolver o rodear cualquier situación. El software es lo suficientemente inteligente como para identificar fallos potenciales y desarrollar respuestas acorde a los problemas que aparezcan, y de, incluso, proporcionar información y sugerencias para mejorar todavía más el sistema. Un sistema muy

potente. La ciencia la proporcionarán cuatro investigaciones. El primero es FIELDS, el Experimento de Campo. Se compone de un juego de cinco antenas y dos conjuntos de magnetómetros. El sistema de antenas servirá para un doble propósito: como sensores de campos eléctricos e instrumento de ondas de radio y plasma. Cuatro de las antenas quedan situadas justo detrás del TPS, y se proyectarán más allá del borde del escudo solar, por lo que quedarán expuestas por completo a la luz y la irradiación solar. Durante el lanzamiento, estas cuatro antenas (V1-V4) estarán guardadas dentro de sendos tubos de molibdeno, y plegadas contra la viga de soporte del TPS, tubos que a su vez tienen pequeños escudos en forma de chevron elaborados en niobio. Las antenas en sí, también construidas en niobio, miden dos metros de largo cada una, y llegarán a soportar temperaturas superiores a los 1300º C. Todo este paquete está aislado, componente a componente con piezas de zafiro. Un preamplificador unirá todas las antenas a los distintos sistemas situados en el interior del cuerpo de la sonda. La quinta antena (V5) se sitúa casi al extremo del mástil, con un par de cortas antenas saliendo de cada lado del preamplificador propio. Para los estudios eléctricos y magnéticos, las antenas están conectadas a un dispositivo llamado Muestreador de Dominio Temporal, o TDS, donde se obtendrán y procesarán todas estas señales, mientras que las funciones de sensor de ondas de radio y plasma las ocupa el Espectrómetro de Radio Frencuencia, que solo trabaja con las cuatro antenas que rodean el TPS. En cuanto a los magnetómetros, lleva tres: dos (MAGi y MAGo) son los típicos sensores de núcleo saturado triaxiales, con gran herencia en decenas de misiones anteriores, como MAVEN o STEREO, por ejemplo. Una vez el mástil queda desplegado, el sensor interno (MAGi) queda a 1.9 metros del final del bus de la sonda, mientras que el externo está a 2.72 metros de la estructura, de manera que el interno mide el campo magnético propio de la sonda, mientras que el externo registra el campo magnético de ambiente. El tercer magnetómetro es una unidad de bobina de búsqueda. Todo esto queda conectado al denominado Paquete de Electrónicas Principal, que no solo conjuga todo lo contado antes, sino también un ordenador que hará que el sistema funcione autónomamente, se configure por sí solo, procese y almacene la información. Todos los procesos sucederán en la Tarjeta de Control de Datos, que dispone de su propio procesador (una unidad Coldfire de 32-bit, resistente a la radiación) y almacenamiento de datos, con una memoria flash de 32 GB. Todo el paquete FIELDS servirá para hacer estudios in-situ de campos eléctricos y magnéticos, propiedades de las ondas de plasma, perfiles de temperatura y densidad de electrones, así como emisiones de radio interplanetarias, entre otras cosas, como impactos de polvo o el problema de la carga de la propia sonda, porque las superficies iluminadas por el Sol atraen carga positiva, acumulando electrones. Una de las estrategias para subsanarlo ha sido conectar eléctricamente las zonas iluminadas con las que lo estarán en sombra, pero aún así se generará, formando una suerte de "estela" de plasma, que FIELDS podrá medir para eliminar sus efectos sobre las mediciones. La segunda investigación es SWEAP, investigaciones de Electrones, partículas Alfa y Protones del Viento Solar, y también conjuga varios aparatos. Por un lado,

tenemos la Copa de Solar Probe, SPC. Técnicamente, es lo que se conoce como Copa Faraday, e instrumentos de este tipo ya han volado al espacio desde el inicio mismo de la era de la astronáutica. Pero la de Parker Solar Probe es especial. todas las Copas Faraday tienen que mirar al Sol para obtener mediciones, y esta no es menos, por lo que tiene que ser muy tolerante al calor y al tiempo obtener mediciones del viento solar. Como otras, genera sus mediciones a partir de una corriente que generan los iones y electrones al entrar por una rejilla que aplica un alto voltaje variable. Para resistir las brutales temperaturas que tendrá que soportar (más de 1600º C), se han elegido materiales como el tungsteno de alta pureza para la rejilla, niobio puro (para el escudo) y una aleación de molibdeno, titanio y zirconio denominada TMZ, además de zafiro como material aislante en el interior del sistema. SPC posee tres rejillas: de tierra, moduladora de alto voltaje y una segunda de tierra, que además limita la apertura, y las tres aisladas del resto por piezas de zafiro. El sensor en sí está formado por cuatro piezas de niobio, dentro de un aislador de zafiro, y aunque se necesitan tres, se añadió una cuarta para proporcionar redundancia a

las mediciones. SPC está acoplada, en parte, al borde externo del TPS, mirando el flujo de partículas, en el lado opuesto al de la dirección orbital, y tras el instrumento, tras el escudo solar, y colocado sobre la estructura de soporte del escudo, un soporte de titanio que proporciona el acoplamiento físico, y un ensamblaje de electrónicas, la conexión eléctrica y de datos a la sonda. Los otros dos aparatos que dan forma a este paquete se llaman SPAN, Analizadores de Solar Probe, y son dos, SPAN-A (en el lado orbital) y SPAN-B (en el opuesto). En esencia son idénticos, analizadores electrostáticos, similares a muchos ya enviados al espacio, en misiones como Mars Global Surveyor, STEREO, o más recientemente MAVEN. SPAN-A está formado en realidad por dos acoplados en vertical, uno para iones y otro para electrones, al tiempo que la sección de iones incluye un medidor TOF, de Tiempo-De-Vuelo, que realiza sus mediciones calculando el tiempo que necesitan las partículas en llegar al detector, determinando así su masa. SPAN-B solo dispone

de la capacidad de registrar electrones. Todos estos aparatos están controlados por el SWEM, el Módulo de Electrónicas de SWEAP, que también es autónomo en su operación, y cuenta además con almacenamiento de a bordo, con 10 módulos de 8 GB cada uno. En esencia, es una repetición de las electrónicas desarrolladas para los instrumentos de partículas de MAVEN. El propósito de SWEAP es nada menos que registrar la composición en bruto del viento solar, en particular electrones, helio ionizado e hidrógeno, derivando de ello las funciones de distribución de velocidad, temperatura y densidad. IS☉IS, la Investigación de Ciencia Integrada para el Sol, está formada por dos aparatos. cada uno se denomina EPI, Instrumento de Partículas Energéticas, y se han diseñado para rangos energéticos distintos. Primero está EPI-Hi, capaz de medir iones cargados entre 1 y 200 MeV y electrones

de entre 0.5 a 6 MeV, por lo que son partículas MUY cargadas de energía, y para ello cuenta con cinco detectores, que dan forma a tres "telescopios" de partículas, HET (telescopio de alta energía), con dos entradas, y los dos LET (telescopios de baja energía), uno doble y uno individual. Estos aparatos emplean sensores de silicio colocados en su interior, y registran las partículas que entran en cada uno, pudiendo detectar electrones energéticos, protones e iones pesados. El instrumento EPI-Lo es muy novedoso, y como una tarta, está compuesto en "porciones", ocho en total, cada una con 10 pequeñas, totalizando 80. Emplea placas microcanal y detectores de estado sólido como sensores, y en realidad es una suerte de espectrómetro de masa, también tipo TOF, detectado electrones (entre 25 y 1000 keV) e iones (entre 0.04 y 7 MeV para protones, y entre 0.02 y 2 MeV para iones pesados). Quedan situados en el lado que da en la dirección orbital, y aunque están situados lado a lado, cada uno posee su propio interfaz eléctrico y de datos con la sonda, y, como los demás, su control es primordialmente autónomo. La intención con IS☉IS es explorar los mecanismos de la dinámica de las partículas energéticas, incluyendo su origen, aceleración y transporte. Y por último WISPR, la Cámara de Campo Ancho Para Solar Probe Plus. Es la única cámara de a bordo, y

deriva de las Cámaras Heliosféricas de STEREO, aunque en realidad es una adaptación del sistema SoloHI que portará la misión europea Solar Orbiter. Con respecto a las de STEREO, es más pequeña (2.5 veces más), usa sensores de pixel activos tipo CMOS, y proporcionará más resolución. Realmente, no mirarán a nuestra estrella, sino a la corona, y desde su privilegiada vista podrá ver en primera persona la actividad solar. Está compuesto por dos cámaras, con lentes refractoras (5 elementos en la cámara interna, apertura de 7.31 mm., f/3.83, seis elementos en la cámara externa, apertura de 8.08 mm, f/4.04), que cada una entrega la luz a sensores APS de 1920 x 2048 pixels, con dos mitades de 960 x 2048 pixels que pueden leerse independientemente.Una parte importante del sistema son los bafles. Si bien el TPS actúa como primer bafle, el sistema cuenta con hasta tres, el ensamblaje frontal, el ensamblaje para la cámara interna, y uno más pequeño para la externa. Estos bafles son cruciales para suprimir toda luz no deseada procedente del Sol. Registrarán longitudes de onda visible (entre 490 y 740 nm el sistema interno, entre 476 y 725 nm el externo) para así ver cosas como el flujo del viento solar, el plasma, y otras estructuras. En general, obtendrá imágenes para observar la estructura en pequeña escala de la corona, derivar la estructura tridimensional de la corona a gran escala, y averiguar si existen cerca de nuestra estrella zonas libres de polvo. Todo estárá controlado por la IDPU, Unidad de Procesado de Datos del Instrumento, que controla todas las acciones, y procesa las imágenes para encajar en ancho de banda del sistema de comunicaciones, capaz incluso de sumar imágenes para realzar detalles. También dispone de almacenamiento interno, con una RAM estática de 3 Gb como almacenamiento primario, un buffer de memoria también de RAM estática de 160 Mb, y finalmente una flash de almacenamiento en bruto de 33.75 Gb, suficiente como para almacenar datos de dos órbitas. WISPR queda instalado en el lado que ofrece en la dirección orbital, lo que le hace vulnerable a los posibles impactos de micrometeoritos, aunque es una posición necesaria. Se une al bus por cuatro extremidades de dos patas cada una, debido a la forma hexagonal del bus. Por cierto, existe una quinta investigación, que no está en la propia sonda, que se realizará en Tierra, que se basa en teoría y modelado. Se llama Orígenes de la Heliosfera con Solar Probe Plus (HeliOSPP), cuyo investigador principal sirve como Científico de Observatorio, realizando una investigación científica interdisciplinar que se concentra en los objetivos y metas de la misión. Proporcionará al equipo científico que guiará las operaciones información teórica y una valoración independiente del rendimiento científico del proyecto para poder maximizar el retorno científico de la misión. Con todo cargado, y lista para despegar, Parker Solar Probe dará un peso en báscula de 635 kg.

Parker Solar Probe necesitará un gran impulso para situarse en la trayectoria óptima, por lo que debe recurrir a los más grandes. Por ello, para lanzarla, se ha reclutado a uno de los cohetes más potentes de la actualidad: el Delta 4-Heavy. Este lanzador, de combustible criogénicos, es más que capaz de proporcionar la pegada necesaria, para ello cuenta con tres núcleos (dos como aceleradores laterales) que funcionarán al unísono durante parte del lanzamiento, y dos de ellos separándose una vez agoten su combustible. La segunda etapa, con grandes tanques de combustible, también ofrece gran potencia y un notable rendimiento, enviando a la órbita cosas tan pesadas como la primera cápsula de reentrada de la nave tripulable Orion. Pero no es suficiente, por lo que, como cuando se lanzó a New Horizons, necesita algo más que proporcione un empuje adicional. De esta forma, esta será la primera (y seguramente, única) vez que incorporará una tercera etapa, en la forma de un propulsor de combustible sólido STAR-48BV, la variante estabilizada triaxialmente de la etapa superior acostumbrada de los Delta 2 en misiones interplanetarias. Si todo sale bien, el 11 de agosto Parker Solar Probe ya estará en el espacio.

A pesar de utilizar una combinación tan potente, todavía carece de la energía necesaria para llegar al máximo perihelio previsto. Por ello, el plan de misión es el de acercarse gradualmente, y para ello se ha decidido usar la gravedad de Venus para ir reduciendo progresivamente el perihelio, y con él, la órbita. El primer sobrevuelo a Venus ocurrirá, si se lanza a tiempo, el 28 de septiembre, y eso llevará al primer perihelio el 1 de noviembre. La primera órbita al Sol durará 168 días, pero después de completar los otros seis previstos hasta el 2024, se encontrará en una trayectoria de 88 días de duración, cumpliendo su perihelio mínimo. El primer perihelio lo realizará a la "conservadora" distancia de 0.15 unidades astronómicas, más o menos unos 22.5 millones de km. de nuestra estrella. La misión primaria se ha programado para durar unos siete años, realizando, además de los sobrevuelos venusinos, 24 órbitas al Sol.

Tras el lanzamiento, y después del despliegue de sus apéndices (paneles solares, mástil del magnetómetro), el agua del sistema de refrigeración de los paneles solares será liberada, después de haber estado almacenada en un tanque calentado, para evitar su congelación en el sistema. Una válvula liberará parte del agua, yendo, empujada por una bomba de dos velocidades, a dos de los cuatro radiadores, porque cada uno está dividido en dos secciones, y el sistema empezará a refrigerar los paneles. El resto del agua permanecerá en el tanque otros cuarenta días, hasta ser liberada en el resto del sistema. Todo esto se hará autónomamente. En los primeros días, todo serán pruebas de los sistemas, incluyendo la instrumentación, así como la obtención de datos para la navegación y posteriores maniobras correctoras previas al primero sobrevuelo a Venus. Con todo esto terminado, y tras el sobrevuelo, se cargará en la sonda el programa para el primer perihelio, para que la sonda actúe partiendo de estas secuencias. Las operaciones, por simplicidad, se han separado en dos etapas. La más importante, la fase de encuentro solar, durará unos 11 días, a partir

del momento en que la sonda está por debajo de las 0.25 unidades astronómicas. En esta fase, los instrumentos están operando al 100% de su capacidad, empezando en el modo por defecto (exploración) para cambiar autónomamente a modo ráfaga, recogiendo datos a la cadencia máxima de cada aparato, guardándola en los grabadores. En esta etapa las comunicaciones estarán muy limitadas, de ahí tanto énfasis en el almacenamiento. Cuando sale de la fase de encuentro solar, empieza la de crucero y descarga, que estará dominada principalmente por la transmisión de todos (o casi) los datos recabados. En esta fase, no solo habrá descarga, también contactos para conseguir información de rumbo, realizar maniobras, y si hay energía suficiente, mantener los instrumentos encendidos para recoger datos a un modo más bajo, que puedan servir de comparativa con lo recogido en las proximidades de Helios. Al tiempo, se cargará en los ordenadores el programa de la siguiente órbita. En general, las órbitas se planificarán con mucha antelación, de modo que pueden darse casos de que no se pueda responder a lo que pueda encontrarse en los datos de una órbita anterior. A medida que Parker Solar Probe se aleja del Sol, será posible no mantener una rígida actitud. De hecho, una vez superadas las 0.7 unidades astronómicas, se permitirá cierta desviación respecto a la posición durante el perihelio, para apuntar la antena principal a la Tierra, y más allá de las 0.82 unidades astronómicas, el posicionamiento será todavía menos rígido, desviándose hasta 45º de la línea horizontal, hacia atrás de la dirección orbital, con tres propósitos: apuntar mejor la antena principal, evitar la congelación del agua en el sistema de refrigeración, y reducir el uso de los calentadores de la plataforma.

El proceso de planificar las operaciones lo realizarán varios equipos coordinados, que establecen lo que la sonda debe hacer durante la órbita en cada momento. Además, en la sonda se ha colocado una herramienta de software que decidirá la prioridad para la descarga de la información almacenada. La prioridad máxima tendrá categoría 0, y la mínima, categoría 9. La primera prioridad solo se ejecutará para telemetría de estado de la sonda en caso de algún problema que no puede resolver. La prioridad 1 está fijada para la telemetría de estado de la sonda y los instrumentos, para confirmar su estado tras cada perihelio. El resto puede variar, de categorías 2 a 9 dependiendo de la importancia que se le de partiendo de las decisiones de los distintos equipos de planificación, especialmente del Grupo de Trabajo Científico. Cuando llega el momento de transmitir, la sonda se atiene a las categorías, emitiendo la información marcada como de máxima prioridad primero, y luego siguiendo la lista. Cada programa quedará fijado con meses de anticipación, en la secuencia que se enviará a la sonda mucho antes de comenzar la nueva fase. En el resto de operaciones, Parker Solar Probe actuará autónomamente.

La misión se ha diseñado para estudiar los procesos y las dinámicas que caracterizan a la corona y al viento solar, y por ello debe entrar en la misma corona. Una vez dentro, la sonda adquirirá información completamente nueva de un entorno desconocido, ayudando a resolver problemas como el seguimiento del flujo de la energía que calienta la corona, y que acelera el viento solar; determinar la estructura y la dinámica del plasma y de los campos magnéticos en las fuentes del viento solar; y explorar los mecanismos que aceleran y transportan las partículas energéticas. Todo esto puede ayudar a pronosticar, en conjunto con los datos recogidos desde otros puntos del sistema solar, los periodos de máxima actividad solar y los momentos en que nuestra estrella puede emitir fenómenos peligrosos como llamaradas, eyecciones de masa coronal y producir tormentas geomagnéticas.

Es una misión muy esperada, y deseada, y al fin está a punto de salir. Decir que es crucial es quedarse corto. Después de explorar las desconocidas regiones exteriores, es el turno de hacerlo con las enigmáticas regiones interiores. Y si al fin no se producen más retrasos en su desarrollo, y se cumple la fecha fijada actualmente, en el año 2020 será lanzada la misión europea Solar Orbiter, que ofrecerá información complementaria a la que recoja Parker Solar Probe, y que de hecho trabajarán coodinadamente para un retorno máximo de información. Mucha suerte.

En la cara que dará al Sol, un recubrimiento reflejará todavía más la luz para no iluminar en exceso el escudo. La intención no solo es proteger la sonda tras él, es la de crear una zona de sombra (la umbra) en la que los distintos apéndices que, en condiciones normales sobresaldrían, queden dentro de ella durante los perihelios. El TPS se une al resto de la sonda con un ensamblaje de soporte en forma de viga, construida usando tubos elaborados en grafito. De esta manera, se pone cierta distancia entre el TPS y la plataforma. El bus es un prisma hexagonal, de 1 metro de diámetro, y ofrece las superficies de montaje interno y externo para los distintos componentes. Se ha construido en aluminio, por ligereza y resistencia. Por toda ella, se han instalado los distintos componentes, tanto internamente como externamente. Su sistema informático se basa en un módulo de electrónicas integrado o IEM, usando con éxito en misiones como MESSENGER o New Horizons, pero con una configuración distinta: en esta ocasión alberga nada menos que triple redundancia en los componentes principales, como la tarjeta del procesador, grabador de estado sólido, y otros elementos. Por primera vez en una misión de la NASA, el

procesador empleado es el LEON3, estrenado en el espacio por la misión europea PROBA, aún en funciones, y ofrece rendimiento más que de sobra para todas las funciones de a bordo. La idea de la triple redundancia es la de poder continuar las operaciones en caso de problemas (reseteo, fallo, etc) en el procesador principal. De los tres, uno de ellos es el primario, gestionando todas las operaciones de a bordo, mientras que el segundo está como repuesto en caliente, listo para tomar el mando si el primario sufre alguna contingencia, y el tercero está como repuesto en frío. Un controlador de redundancia será quien tome la decisión de saltar de procesador a procesador, activándolos y desactivándolos como mejor convenga a la misión. La intención es no perder ni un momento de recogida de datos, que se irán guardando en los grabadores asociados al procesador principal y al situado en condición de repuesto en caliente. Cada grabador puede almacenar hasta 128 Gb de datos, suficiente para dos órbitas en torno al Sol. Para transmitir todo este flujo a Tierra, usa distintas configuraciones en su sistema de comunicación. Parker Solar Probe emplea un sistema de banda dual, de banda-X y banda-Ka, y la distribución de antenas es, cuanto menos, curiosa. Como toda sonda de espacio profundo, equipa una antena parabólica de alta ganancia, y esta es de 0.6 metros de diámetro, y móvil para poder apuntarla hacia la Tierra. Trabaja exclusivamente en banda-Ka, para transmitir datos a alta velocidad al centro de control (167 kbps). El resto usa banda-X, y son un par de antenas de media ganancia (tipo haz de abanico) y un par de baja ganancia. La antena principal y las de media ganancia se ubican en un único lado (el opuesto al orbital) y las de baja ganancia una está en el lado que siempre mirará en la dirección orbital, y la otra en el contrario. Se da la particularidad que esta misión estrena, en el espacio profundo, un nuevo tipo de radio, desarrollada en el APL, denominada Frontier Radio, cuyos prototipos van en las Van Allen Probes, y para Parker Solar Probe se ha tenido que cualificar el diseño para volar al espacio profundo, de ahí su denominación (Frontier DS). No es que las radios tipo SDST ya no sean válidas (de hecho lo son, y mucho), solo que en el APL les gusta usar desarrollos propios, por ello CONTOUR y New Horizons usaban sistemas propios, desarrollados en el Laboratorio. En cuanto a la generación de energía, lo dicho, paneles solares. Los de esta misión son pequeños, por necesidad, de 1.12 metros de largo y 0.69 de ancho, totalizando 1.55 metros cuadrados de superficie activa, por lo que proporcionarán energía limitada. Cada uno está situados al extremo de un mástil móvil, que se pliega y despliega dependiendo de la distancia solar. el propósito es esconder la sección principal de cada panel (con células de alta eficiencia, herencia MESSENGER) en la umbra creada por el TPS, pero dejar solo las puntas, la sección secundaria, fuera, en una zona de penumbra, que proporcionará hasta 400 W de electricidad en cada perihelio. Las células en la sección secundaria son distintas, y además de alta eficiencia, también son altamente tolerantes a las altas temperaturas, aunque no a las que tendrán que soportar. Estas secciones secundarias tienen una mínima inclinación hacia delante, que les sirve para poder salir de la sombra del TPS. Las células se han situado sobre una lámina de titanio, cuerda por cuerda, siguiendo el ancho del sustrato de titanio. Lo verdaderamente novedoso es que las células solares están refrigeradas de manera activa, un circuito cerrado envía líquido refrigerante para bajar la temperatura y protegerlas del intenso calor. Todo el conjunto de refrigeración se llama SACS, Sistema de Refrigeración de los Paneles Solares, y como líquido refrigerante usa un elemento que cualquiera podría descartar: agua. En realidad, se trata de agua a presión, porque en este estado es más capaz de absorber calor sin evaporarse. Todo el sistema es un circuito cerrado, que bombea el agua a presión (cinco litros en total) desde el tanque de almacenamiento hasta los paneles, de ahí se lleva el calor hasta dos enormes radiadores de tubos de titanio situados en la estructura que soporta el TPS, y luego vuelve al tanque. El sistema es realmente efectivo, capaz de disipar hasta 6500 vatios de calor y mantener las células solares en las secciones secundarias a unos más templados 150º C. A pesar de estar la energía limitada, las electrónicas son de bajo consumo, y a distancias inferiores a la unidad astronómica generan la suficiente para activar todos los sistemas de a bordo, y cargar una batería de ión litio. Estará estabilizada en sus tres ejes, y para ello recurre a lo habitual: unidad de medición inercial, dos escáneres estelares, sensores solares, 4 ruedas de reacción y propulsores. Como con MESSENGER, los requerimientos de actitud son severos. En la fase de perihelio (11 días en total) Parker Solar Probe debe ofrecer, por obligación, el TPS hacia el Sol para crear la umbra. La sonda mantendrá la posición primordialmente usando un juego de sensores solares denominados SLS, sensores de limbo solar, que se proyectan desde la plataforma, y señalarán al sistema de control de actitud una violación en los requisitos, para que la sonda maniobre de vuelta a la actitud óptima. Todas las maniobras se realizarán usando las ruedas de reacción, desaturadas por los propulsores, que porta en total 12, que se usarán también para correcciones de rumbo. El resto del control termal es más bien básico: mantas multicapa, ventanillas de apertura por termostato, tratamientos superficiales y calentadores eléctricos. Parker Solar Probe es la sonda que más autonomía incorporará, por necesidad principalmente, en sus operaciones y en su protección contra fallos. Aunque todo estará guiado por los comandos cargados desde el centro de control, la sonda realmente requiere poca atención, siendo capaz de realizar cualquier cosa por sí misma. A diferencia de otras sondas, que poseen ordenadores propios para controlar su actitud, Parker Solar Probe lo ejecuta todo en el ordenador de a bordo. Por su orden, pliega o despliega los paneles solares, mantiene o corrige su actitud, y responde a cualquier anomalía surgida a bordo. De esta forma, su software de protección contra fallos posee mucha más autoridad que sistemas similares. No solo detectará y aislará los problemas que surjan (que con condiciones normales provocaría un modo seguro), sino que también tratará de resolver o rodear cualquier situación. El software es lo suficientemente inteligente como para identificar fallos potenciales y desarrollar respuestas acorde a los problemas que aparezcan, y de, incluso, proporcionar información y sugerencias para mejorar todavía más el sistema. Un sistema muy

potente. La ciencia la proporcionarán cuatro investigaciones. El primero es FIELDS, el Experimento de Campo. Se compone de un juego de cinco antenas y dos conjuntos de magnetómetros. El sistema de antenas servirá para un doble propósito: como sensores de campos eléctricos e instrumento de ondas de radio y plasma. Cuatro de las antenas quedan situadas justo detrás del TPS, y se proyectarán más allá del borde del escudo solar, por lo que quedarán expuestas por completo a la luz y la irradiación solar. Durante el lanzamiento, estas cuatro antenas (V1-V4) estarán guardadas dentro de sendos tubos de molibdeno, y plegadas contra la viga de soporte del TPS, tubos que a su vez tienen pequeños escudos en forma de chevron elaborados en niobio. Las antenas en sí, también construidas en niobio, miden dos metros de largo cada una, y llegarán a soportar temperaturas superiores a los 1300º C. Todo este paquete está aislado, componente a componente con piezas de zafiro. Un preamplificador unirá todas las antenas a los distintos sistemas situados en el interior del cuerpo de la sonda. La quinta antena (V5) se sitúa casi al extremo del mástil, con un par de cortas antenas saliendo de cada lado del preamplificador propio. Para los estudios eléctricos y magnéticos, las antenas están conectadas a un dispositivo llamado Muestreador de Dominio Temporal, o TDS, donde se obtendrán y procesarán todas estas señales, mientras que las funciones de sensor de ondas de radio y plasma las ocupa el Espectrómetro de Radio Frencuencia, que solo trabaja con las cuatro antenas que rodean el TPS. En cuanto a los magnetómetros, lleva tres: dos (MAGi y MAGo) son los típicos sensores de núcleo saturado triaxiales, con gran herencia en decenas de misiones anteriores, como MAVEN o STEREO, por ejemplo. Una vez el mástil queda desplegado, el sensor interno (MAGi) queda a 1.9 metros del final del bus de la sonda, mientras que el externo está a 2.72 metros de la estructura, de manera que el interno mide el campo magnético propio de la sonda, mientras que el externo registra el campo magnético de ambiente. El tercer magnetómetro es una unidad de bobina de búsqueda. Todo esto queda conectado al denominado Paquete de Electrónicas Principal, que no solo conjuga todo lo contado antes, sino también un ordenador que hará que el sistema funcione autónomamente, se configure por sí solo, procese y almacene la información. Todos los procesos sucederán en la Tarjeta de Control de Datos, que dispone de su propio procesador (una unidad Coldfire de 32-bit, resistente a la radiación) y almacenamiento de datos, con una memoria flash de 32 GB. Todo el paquete FIELDS servirá para hacer estudios in-situ de campos eléctricos y magnéticos, propiedades de las ondas de plasma, perfiles de temperatura y densidad de electrones, así como emisiones de radio interplanetarias, entre otras cosas, como impactos de polvo o el problema de la carga de la propia sonda, porque las superficies iluminadas por el Sol atraen carga positiva, acumulando electrones. Una de las estrategias para subsanarlo ha sido conectar eléctricamente las zonas iluminadas con las que lo estarán en sombra, pero aún así se generará, formando una suerte de "estela" de plasma, que FIELDS podrá medir para eliminar sus efectos sobre las mediciones. La segunda investigación es SWEAP, investigaciones de Electrones, partículas Alfa y Protones del Viento Solar, y también conjuga varios aparatos. Por un lado,