Cuando se planea una misión, una que busca llegar a un lugar remoto o a un objetivo esquivo, las asistencias gravitatorias están a la orden del día. Planetas como Venus, la Tierra, incluso Júpiter son los objetivos obvios. Más extraño resulta realizarlo a un planeta que es, a día de hoy, el más visitado.

¿Marte, como estación de paso? Resulta que son pocos los que miran al Planeta Rojo a la hora de hacer un sobrevuelo. Venus, claro, tiene buena masa, y como la Tierra es algo mayor, obviamente en el sistema solar interior son las elecciones obvias. Si por Marte no se ha hecho hasta recientemente ha sido porque no resultaba ventajoso. Sólo por las alineaciones planetarias se puede aprovechar su gravedad y, bueno, se trata de un empujón que no se puede menospreciar.

No fue hasta el año 2007 que una sonda espacial practicó una asistencia gravitatoria a Marte. Sí, ya otras misiones, en los años Sesenta, pasaron por allí, y la gravedad marciana alteró sus rutas, pero sin destinos diferentes del sistema solar.

|

Marte... ¿morado? (Combinación

de filtros naranja, verde y

ultravioleta cercano)

Fuente: ESA & MPS

for OSIRIS Team

MPS/UPD/LAM/

IAA/RSSD/INTA/

UPM/DASP/IDA, 2007 |

En su largo trayecto hacia el cometa 67P/Churyumov-Gerasimenko, la misión

Rosetta tuvo que tomar prestada mucha energía orbital, no sólo de tres acercamientos a la Tierra, sino que también uno a Marte, ya que estaba por allí. Acaeció el 25 de febrero del año 2007, con la sonda pasando a 250 km. de la superficie, en la cara nocturna del Planeta Rojo. Nos entregó imágenes estupendas del planeta, además de cumplimentar la maniobra que tenía preparada. Una asistencia gravitatoria complicada que se ejecutó con brillante éxito, como el resto de su misión.

Casi dos años después, fue otra misión compleja como

Dawn la que practicó la maniobra. Programada para el 17 de febrero del 2009, la sonda a impulsión iónica (por muchos, incluso un servidor, considerada la primera nave espacial de la historia) se aproximó al planeta a 549 km. de su superficie. Una entrada en modo seguro por un pequeño error en la programación de sus instrucciones entorpeció su obtención de datos de prueba, pero aún así nos mostró un pequeño retazo de las formas geológicas del Planeta Rojo.

Y hasta la fecha...

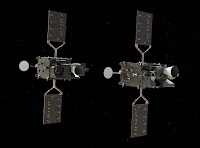

A la hora de preparar las entradas para las misiones Hera y Europa Clipper nos dimos cuenta que no sólo compartían base de lanzamientos, y empresa lanzadora. Sus despegues estaban separados por apenas una semana. Aún más, prácticamente ambas tenían una ruta de salida virtualmente idéntica, que les puso de camino directo hacia Marte para así aprovechar su gravedad. Curioso, ¿no?

Claro, hay que entender la energía de los lanzamientos al ver que la primera en pasar por Marte fue la segunda lanzada, y con buen margen. Y, ya que se pasa, qué mejor que tomar unas cuantas fotos de un lugar del que obtenemos imágenes a diario. Veamos qué han conseguido estas dos.

El 1 de marzo,

Europa Clipper pasó a 884 km. de la superficie marciana, con el objetivo de acumular velocidad y ponerse en rumbo de retorno a la Tierra, antes de marchar directo a Júpiter. La verdad, era una oportunidad demasiado buena para no aprovecharla. Aunque, la verdad, resultó quizás algo decepcionante. Nos explicamos: desde el año 2001, en Marte está

Mars Odyssey, y su cámara termal THEMIS. Da la casualidad que a bordo de la sonda a Europa está E-THEMIS, una evolución de ese sistema. Eso significaba realizar una intercomparación entre ambos sistemas. Claro, hubiéramos esperado ver imágenes mejores, pero... Se optó porque E-THEMIS capturara imágenes de Marte aproximadamente un día antes de la máxima aproximación, a una distancia de más o menos 1.6 millones de km. del planeta. No hace falta decir que no son imágenes especialmente sugerentes, para nada. Pero sí han

|

Fuente de ambas:

NASA/JPL-Caltech/ASU |

resultado útiles para poder ver que es capaz de registrar la temperatura con un alto grado de exactitud, sobre todo comparando sus registros con el THEMIS de

Mars Odyssey. ¿Decepcionante? Sin duda alguna. Ah, y otro de los instrumentos de

Europa Clipper también se probó, esta vez en las proximidades de Marte. Se trata de su radar subsuperficial REASON. Carecemos de información sobre si ha revelado algo interesante en esta prueba, pero según lo informado, operó sin problemas, puesto que en Tierra fue imposible probar semejante sistema. Y por último, se obtuvo la verificación de la funcionalidad del experimento de radio ciencia. ¿Por qué no se probó, por ejemplo, el sistema de cámaras EIS? Porque sus cubiertas no se abrirán hasta pasado el sobrevuelo terrestre, ya en el año 2027. Eso sí, se ha probado su funcionalidad, y no parece haber problemas de momento. En fin, decepcionante...

Si el paso de

Europa Clipper te dejó con ganas de más, o con mal sabor de boca, dos semanas después fue el turno de la misión europea

Hera. En su camino al asteroide binario Didymos-Dimorphos, la pequeña sonda aprovechó la visita marciana para coger energía orbital y así acortar su camino de camino a su destino. Y aunque mucho más modesta que la sonda de la NASA, nos ha entregado mejores resultados. Claro, su destino está a ojos vista... En fin, que la sonda está bien equipada para el estudio de cualquier cuerpo celeste, y quedó ampliamente demostrado en el acercamiento a Marte. En su caso, la distancia fue más lejana, con una máxima aproximación a unos 5700 km. de la superficie marciana, pero pasando hasta 300 km. de su luna más lejana y menos conocida como es Deimos. Y esa era una oportunidad que, para nada, se iba a dejar pasar.

En un despliegue de lo más interesante, la ESA decidió hacer una emisión en directo para que todos pudieran ver las imágenes según se recibían desde Hera (teniendo en cuenta, por supuesto, el retardo en la señal de comunicaciones). Y fueron imágenes de los tres sistemas principales en ese sentido: la cámara AFC, el espectrómetro hiperespectral Hyperscout-H y el sistema termal japonés TIRI. Eso significa toda una galería de imágenes.

Todas las imágenes que tenemos las tomó cuando

Hera se situaba a 1000 km. de Deimos. En ellas se evidencia la diferencia en campo de visión de las tres cámaras. AFC nos mostró el satélite más pequeño de Marte como una mota oscura frente a la más brillante superficie del planeta. Los cráteres resultan sin duda evidentes en Marte, con el cráter Huygens en la parte superior, y en la esquina inferior derecha, una parte de la cuenca Hellas.

|

Pero... ¿no habíamos quedado que Marte

era rojo? Imagen en infrarrojo

cercano (Fuente: ESA) |

Como se puede ver, el campo de visión de Hyperscout-H es mucho mayor, abarcando, desde la misma distancia, casi la mitad del planeta. La cuenca Hellas podemos verla casi en su totalidad, así como diversos cráteres de grandes proporciones, no sólo el Huygens, también el Schiaparelli. La zona brillante en la parte superior es una zona más brillante, la región de Terra Sabaea. Y Deimos sigue apareciendo como una mancha oscura flotando en el espacio. Muy interesante.

De TIRI, poseemos dos cosas. La primera es una imagen termal de la misma región aproximada. Los colores más oscuros reflejan temperaturas más frías, los más claros... Bueno, está claro. Y aquí tenemos la cuenca Hellas como una zona fría, pero Deimos como una mota realmente brillante. ¿Por qué? Al carecer de atmósfera, es como la Luna, y otros satélites semejantes: se calienta muy fácilmente. Claro, si tenemos en cuenta que el material de la superficie del satélite es más oscura, resulta que, al igual que el asfalto o el carbón, atrapa el calor con mayor facilidad. Marte, al estar cubierta su superficie de regolito, tarda más en calentarse. De hecho, temperaturas de más de veinte grados en superficie es todo un récord en el planeta. La segunda es una

secuencia de los últimos segundos de su aproximación al segundo satélite marciano hasta que, en la última, está a unos 1000 km. de Deimos. Sin código de color, el pequeño satélite con forma de haba sigue destacando como más brillante que Marte, además de poder ver las distintas regiones del planeta también con diferencias de temperatura por su mayor o menor oscuridad.

|

| Fuente: ESA/GMV |

Esto no es todo:

Hera posee un sistema de navegación autónomo basado en formaciones superficiales, semejante al que tuvo que usar

OSIRIS-REx en Bennu durante su exploración. Puesto que el control remoto directo de una sonda en el espacio profundo es imposible, la ESA ha desarrollado esta herramienta. Vinculada a la cámara AFC, se probó en Marte cuando el planeta abarcaba todo el campo de visión del sistema. Este sistema autónomo, desarrollado por un equipo de la firma

GMV de España y Rumanía, fue capaz de registrar y rastrear más de cien formas superficiales (mayormente cráteres) durante veinte minutos, en una prueba que, en Tierra, resulta imposible de poder hacer.

Ya lo veis, dos sobrevuelos, dos éxitos, sin el Drama Marciano influyendo en estas dos visitas. Y, como podéis comprobar, da igual que sea poca la ayuda que Marte pueda proporcionar, pero es suficiente, hasta el punto de que Hera, gracias a un sobrevuelo tan efectivo, ha podido acortar en un mes su tiempo de viaje hacia su destino, para poder llegar al sistema binario Didymos-Dimorphos no en diciembre del 2026, sino en noviembre.

Venus sigue siendo la reina de las asistencias gravitatorias en el sistema solar interior, con maniobras que datan de 1974 y

Mariner 10, y más recientemente aprovechadas por

Parker Solar Probe y

Solar Orbiter, con el próximo sobrevuelo para poco menos de dos meses con

JUICE. Ah, y para que conste, el año que viene toca otro acercamiento a Marte para una maniobra semejante: la prima hermana de

Dawn, la sonda

Psyche, también aprovechará la gravedad del planeta rojo para acortar su tiempo de viaje a su destino. Tras superar unos problemas en su sistema de impulsión iónica, la misión sigue en plazo para el sobrevuelo.

Con retraso, sí, pero aquí informamos de todo lo que se pueda. Tal vez estas sean operaciones poco interesantes para algunos, pero vitales para las misiones en marcha. Ya sabéis: las sondas no están ahí arriba aburriéndose por el espacio. Tienen sus propias tareas que cumplir. Como todos.